Ollama如何开启非本机访问权限?端口更换及监听

发布于 作者:苏南大叔 来源:程序如此灵动~

目前通过ollama运行大模型,是个非常通常的操作。但是,由于这些大模型都比较消耗资源。所以,ollama和调用api的机器可以考虑分开部署,就是个比较常见的操作。这个时候,需要设置一个全局变量OLLAMA_HOST,对ollama进行调整,才能实现这个操作。否则,ollama只能在本机上面使用。

苏南大叔的“程序如此灵动”博客,记录苏南大叔的代码编程经验总结。本文测试环境:win10,ollama@0.6.2,deepseek-r1:7b。

前文回顾

ollama的安装及如何运行deepseek-r1:7b:

如何通过open-webui,图形化的使用本地的ollama:

如果是mac系统,可以参考下面这篇文章:

OLLAMA_HOST

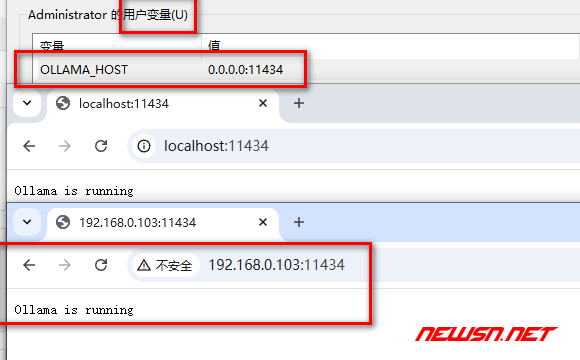

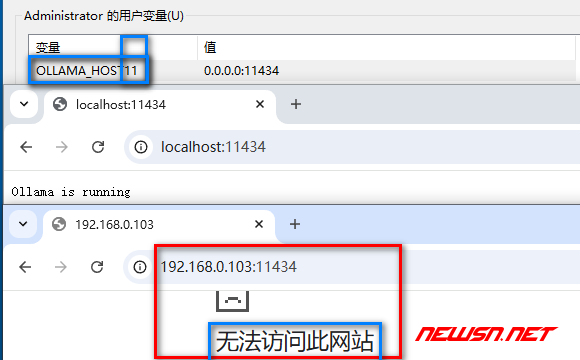

需要设置一个用户环境变量OLLAMA_HOST,为0.0.0.0:11434。(当然,也可以换个其它端口号)。

然后重启ollama(右下角托盘区有ollama图标)。

OLLAMA_MODELS

顺便回顾一下,如何移动大模型的本地位置。解决方案是通过OLLAMA_MODELS环境变量来实现的。这样,就可以节约宝贵的系统盘的硬盘空间了。

结语

这里修改OLLAMA_HOST,是为了后续配置dify的“大模型设置”选项,而做的伏笔文章。