运行scrapy爬虫时,提示不能识别crawl命令,该如何处理?

发布于 作者:苏南大叔 来源:程序如此灵动~

近期,苏南大叔在箱子底里面翻出了一个scrapy项目,因为目标网站改版,所以需要修复一些抓取规则。在调试的过程中,发现了一些小问题,比如本文中所描述的一个弱智问题,非常弱智。但是,估计读者你还是犯了这个问题了吧?否则不可能搜索过来这个页面。

本文测试环境:scrapy@1.8.0,mac。事情的经过就是苏南大叔试图运行一个以前的scrapy项目的时候,得到了一个Unknown command: crawl的错误信息。

报错信息

Unknown command: crawl的完整报错信息如下:

bogon:~ sunan$ scrapy crawl article2

Scrapy 1.8.0 - no active project

Unknown command: crawl

Use "scrapy" to see available commands查看scrapy命令的帮助信息的话,确实没有crawl这个选项。但是,这个并不是事情的真相。

bogon:~ sunan$ scrapy

Scrapy 1.8.0 - no active project

Usage:

scrapy <command> [options] [args]

Available commands:

bench Run quick benchmark test

fetch Fetch a URL using the Scrapy downloader

genspider Generate new spider using pre-defined templates

runspider Run a self-contained spider (without creating a project)

settings Get settings values

shell Interactive scraping console

startproject Create new project

version Print Scrapy version

view Open URL in browser, as seen by Scrapy

[ more ] More commands available when run from project directory

Use "scrapy <command> -h" to see more info about a command解决方案

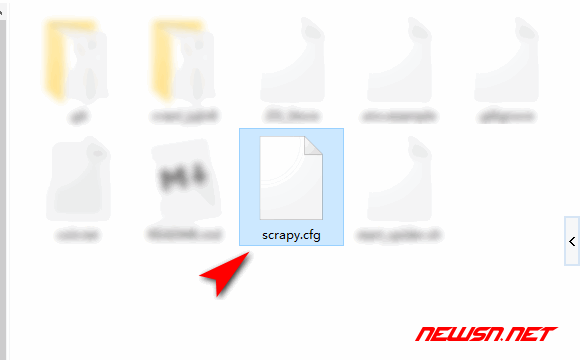

解决方案其实挺鉴定,就是运行scrapy命令的位置,是有问题的。寻找一下相关scrapy项目的scrapy.cfg文件所在的目录,然后在在这个位置上,运行scrapy crawl xxx即可。如下图所示:

相关链接

下面的链接是官方文档里面的相关描述:

如果您在查找如何开始一个新的scrapy爬虫,您可以查看下面这篇文章:

总结

本文的解决方案非常简单,就是找到scrapy.cfg文件的位置,然后再当前目录下面执行crawl命令即可。

scrapy作为基于python的抓取框架,还是非常值得大家学习的。更多scrapy的内容,请点击苏南大叔的博客: